У меня ноутбук с OLED-дисплеем, поддерживающим DCI-P3 и с видеокартой AMD. И в ходе недавнего обсуждения всплыл вопрос про HDR в Linux.

А ведь две недели назад вышел KDE 6.0, в котором обещали начальную поддержку HDR в сеансе Wayland. Ну, я и скачал. Ну я и запустил.

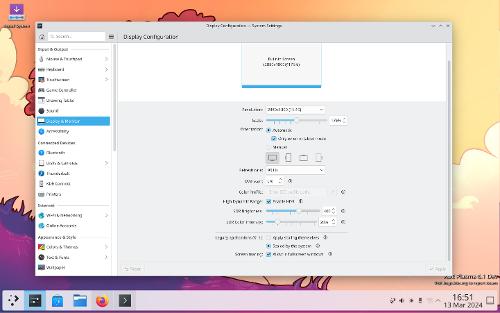

А оно взяло и заработало. Цвета поехали, яркости маппинга SDR пришлось добавить, цветности тоже. К сожалению, вы этого не заметите, потому что Spectacle мапит HDR скриншоты обратно в SDR, чтобы они влезли в PNG, и не кладёт ICC. Непорядок. Всё, что вы можете увидеть, это заветную галочку и слегка вырвиглазные цвета иконок.

Придётся поверить мне на слово: оно работает. Осталось дождаться стабилизации, поддержки со стороны браузера, медиаплеера, игрушек и всего такого.

В чём заключается начальность поддержки HDR я не понял, поддержка HDR лучше чем в винде 10, там таких регулировок нет :-)

P.S. KDE Neon unstable, live USB.

>>> Просмотр (2881x1801, 956 Kb)